План-конспект урока информатики Пономаренко Е.В.

Тема «Информация, информационные процессы, количество информации»

- 1. “Разминка”, подводящая к проблеме измерения информации

На доске записаны два информационных сообщения:

“абракадабра” и “завтра зачет”.

Учитель: “В каком сообщении информации больше?”

(Некоторые ученики могут ответить, что во втором — в нем есть полезная информация, другие могут сказать, что в первом, т.к. в нем меньше символов.)

2. Учитель: “Сравните количество информации в двух словах: стол и table”.

(По количеству символов в первом слове информации меньше, но многие ученики могут заметить, что смысл обоих слов одинаков; не знакомые с английским языком могут сказать, что для них более информативно первое слово.)

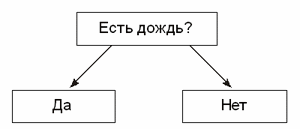

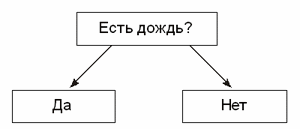

3. Учитель просит трех учеников задать ему один и тот же вопрос: “Идет ли на улице дождь?” Первому ученику учитель отвечает “Да”, второму — “Yes”, а третьему просто кивает головой (полезно изобразить ответы на доске: “Да”, “Yes”, “+”).

После этого учитель спрашивает, получил ли каждый из учеников информацию. Ученики ответят, что да — получили.

Учитель: “Одинаковое ли количество информации вы получили в каждом случае?” (После множества высказанных версий чаще всего учащиеся приходят к выводу, что количество символов в ответах разное, но содержание ответов — одинаково.)

Таким образом, возникает проблема — как измерить количество полученной информации не с технической точки зрения (с точки зрения количества символов), а с точки зрения ее содержания?

2. Два подхода к измерению информации

К измерению количества информации можно подходить с разных позиций.

1. Можно измерять количество информации в контексте компьютерного представления информации — такой подход называется “алфавитным”. Он не связан с содержанием текста.

2. Содержательный подход подразумевает оценку содержания полученной информации с точки зрения ее полезности. При этом под полезной частью информации понимается та часть сообщения, которая снимает полностью или уменьшает существовавшую до ее получения неопределенность какой-либо ситуации.

Впервые такую трактовку информации ввел американский ученый и инженер Клод Шеннон в своей работе “Математическая теория связи”, опубликованной в 1956 году.

3. Клод Шеннон. Краткая биографическая справка

Шеннон (Shannon) Клод Элвуд (1916–2001), американский ученый и инженер, один из создателей математической теории информации. Окончил Мичиганский университет (1936 г.).

В 1941–1957 гг. — сотрудник математической лаборатории компании “Bell System”. С 1941 г. — советник национально-исследовательского комитета Министерства обороны США. С 1957 г. — профессор электротехники и математики Массачусетсского технологического института. С 1956 г. — член национальной Академии наук США и Американской академии искусств и наук. Основные труды по алгебре логики, теории релейно-контактных схем, математической теории связи, информации и кибернетике.

Сочинения в русском переводе: Работы по теории информации и кибернетике. М., 1963.

4. Обсуждение определения понятия “информация” Клода Шеннона

На доске запись:

“Информация — это снятая неопределенность”

Клод Шеннон

Учитель: “Как вы понимаете это определение? Что означает слово “неопределенность”? Приведите синонимы этого слова. (Неизвестность, незнание и т.д.)

А что означает понятие “снятая неопределенность”?

Под информацией Клод Шеннон понимал не любые сведения, а лишь те, которые снимают полностью или уменьшают существующую до их получения неизвестность (неопределенность).

Пример

Я не знаю, есть ли на улице дождь, — неопределенность. Я вас спрашиваю, есть ли на улице дождь? Получив ответ, моя степень информированности о погоде на улице изменилась. Как?

Если вы ответили “Да”, то увеличилась. Но если вы ответили “Нет”, то тоже увеличилась! (Я знаю, что дождя нет.)

Итак, одинаковое ли количество информации в этих двух ответах? Иными словами, в одинаковой ли степени уменьшилась неопределенность, которая была до этого? (Да.)

Следующий вопрос: “какой объем информации я получил(а)?”. (Иногда учащиеся могут ответить, что если ответ “Да”, то 2 байта, если “Нет”— то 3 байта. В этом случае учителю можно привести пример английских вариантов этих слов: “Yes” — 3 байта, “No” — 2 байта; полезно также обратить внимание, что просто кивок головы поможет полностью снять существующую неопределенность, а значит, содержать то, что Клод Шеннон называл информацией.)

5. Вывод формулы Хартли

Учитель: “Рассмотрим еще несколько примеров.

Пример 2

Я подброшу монету, и она упадет или “орлом”, или “решкой”, о чем заранее я не знаю, т.е. существует неопределенность. Одинаковое ли количество информации содержит каждое из двух возможных сообщений о том, какой стороной упала монета?

Такой вопрос: одинакова ли вероятность падения монеты орлом и решкой? (Да, одинакова.)

Так мы подошли к определению единицы измерения количества информации — 1 бит — с точки зрения содержательного подхода:

| 1 бит — это количество информации в сообщении об одном из двух равновероятных событий. |

В нашем случае количество информации в сообщении о том, что монета упала, например, решкой, равно 1 биту. И вообще, в любом ответе на вопрос, предполагающем два варианта ответа (да или нет, орел или решка, больше или нет, черное или белое и т.п.), содержится 1 бит информации.

Пример 3

Книга лежит на одной из двух полок — верхней или нижней (неопределенность). Во сколько раз уменьшится неопределенность после сообщения, что книга лежит на верхней полке? (В два раза.)

Неопределенность снимается полностью? (Да.)

Какое количество информации в ответе на заданный вопрос? (1 бит — на вопрос существует только два варианта ответа.)

Пример 4 — игра

Загадайте любое целое число от 1 до 32.

(Кто-то из учеников записывает это число на доске, учитель может стоять спиной к доске, лицом к детям.)

Считайте, сколько вопросов я задам для отгадывания числа.

Ответ на мой вопрос должен быть да или нет!

(Для отгадывания достаточно пяти вопросов1. Можно повторить игру еще раз или пригласить вызвавшегося отгадывать ученика.)

Как уменьшает неопределенность ответ на каждый вопрос? (Вдвое.)

После пяти вопросов можно отгадать задуманное число — неопределенности не осталось.

Итак, было задано 5 вопросов, каждый из которых предполагал два варианта ответа. Сколько информации нес в себе каждый ответ? (1 бит.) Какое общее количество бит информации было получено до угадывания задуманного числа? (5 бит.)

Следовательно, можно сказать, что при содержательном подходе 1 бит — это количество информации, уменьшающее неопределенность знания в два раза.

Пример 5

Аналогичен примеру 3, но полок — четыре.

В этом случае один вопрос (один ответ) уменьшит неопределенность, но не снимет ее полностью. Сколько надо задать вопросов, чтобы точно знать, на какой полке лежит книга? (Два.)”.

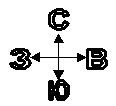

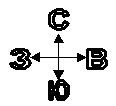

Можно также рассмотреть задачи о направлении ветра: сначала с четырьмя направлениями: север (С), юг (Ю), запад (З) и восток (В):

а потом с восемью: С, Ю, З, В, СЗ (северо-запад), СВ (северо-восток), ЮЗ (юго-запад) и ЮВ (юго-восток).

Учитель: “Сколько вопросов, на которые можно отвечать “Да” или “Нет”, нужно задать, чтобы узнать, в каком направлении дует ветер? (Нужно присвоить каждому направлению условный номер, начиная с 1, и задавать вопросы, аналогичные вопросам в игре на угадывание задуманного числа.)

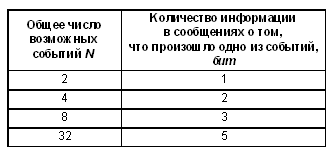

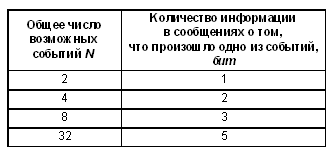

Некоторые итоги

Когда монета может упасть двумя способами (той или иной стороной), то в сообщении о том, что она упала, например, орлом, содержится 1 бит информации.

Чтобы узнать, на какой из четырех возможных полок находится книга, надо получить 2 бита информации. Иными словами, количество информации в сообщении о том, что книга лежит на той или иной полке, равно 2 бита.

В задаче с восемью возможными направлениями ветра количество информации, которое надо получить в ответах, чтобы узнать, в каком направлении дует ветер, равно 3 бита.

Эти сведения и аналогичные сведения об игре на угадывание чисел сведем в таблицу:

Как связаны между собой величина N и количество информации?

(Если количество информации обозначить буквой i, то 2i = N.)

Полученная формула называется “формулой Хартли”.

Вопрос: от чего зависит количество информации в сообщении о том, что произошло одно из нескольких возможных (равновероятных) событий? (Можно сказать, что количество бит информации в таком сообщении совпадает с минимальным количеством вопросов, которые необходимо задать, чтобы полностью снять неопределенность и узнать, какое из событий произошло.)”

6. Задачи для самостоятельной работы

1. Если бы в рассмотренной игре было загадано число от 1 до 16, то сколько вопросов надо задать, чтобы его угадать? (4) Сколько информации будет получено? (4 бита.)

2. Объявляют оценки за контрольную работу. Сколько информации содержит сообщение об оценке очередного ученика? Принять, что все оценки 2, 3, 4 и 5 равновероятны. (2 бита.)

3. Проводится лотерея “5 из 64”. Первым достали шар с № 8. Сколько информации в этом сообщении? (6 бит.)

4. В колоде 32 карты. Сколько информации содержится в сообщении о том, что из колоды достали даму пик? (5 бит.)

5. При угадывании целого числа в диапазоне от 1 до N было получено 6 бит информации. Чему равно N?

6. Сообщение о том, что ваш друг живет на 5-м этаже, несет 4 бита информации. Сколько этажей в доме? (16)

7. Количество информации и вероятность события

Учитель: “Во всех рассмотренных нами примерах все события имеют равновероятные исходы (монета может c одинаковой вероятностью упасть как “орлом”, так и “решкой”, задуманным одинаково вероятным может оказаться любое из 32 чисел и т.п.).

Можно сказать, что вероятность — это ожидаемость события. Она измеряется в долях единицы (от 0 до 1) или в процентах (от 0 до 100%).

Но всегда ли вероятность событий бывает равной?

Вспомним задачу об оценках. Одинакова ли вероятность объявления оценки “2” у отличника и у неуспевающего по данному предмету ученика? (Нет.)

Какое сообщение несет в себе больше информации: о том, что оценку “5” получил отличник или неуспевающий по данному предмету ученик?

Таким образом, количество информации зависит не только от количества возможных вариантов события, но и от вероятности каждого варианта. Причем чем больше вероятность события, тем меньше количество информации в сообщении о таком событии”.

8. Тест по теме “Измерение информации. Содержательный подход”

1. Что из нижеперечисленного не является информацией с точки зрения Клода Шеннона?

1) LIRO CAS2;

2) Сегодня на улице 10 градусов мороза;

3) Хранение, обработка и передача — основные информационные процессы;

4) 24 * 15 = 360;

5) Лед — твердое состояние воды.

2. “Вы выходите на следующей остановке?” — спросили человека в автобусе. “Нет”, — ответил он. Сколько бит информации содержит его ответ?

Ответ: 1 бит.

3. Сколько вопросов надо задать, чтобы отгадать задуманное целое число от 1 до 64?

Ответ: 6.

4. Сообщение “Алиса живет в доме № 23 на улице Вишневая” содержит 5 бит информации. Сколько всего домов на улице?

Ответ: 32 дома.

5. Сколько информации содержит красный сигнал светофора?

1) 1 бит;

2) больше одного, но меньше двух битов;

3) 3 бита;

4) 1 байт;

5) больше двух битов.

6. Во время игры в кости на игральном кубике выпало число 1. Сколько информации содержит это сообщение?

1) 1 бит;

2) 2 бита;

3) больше двух, но меньше трех битов;

4) больше одного, но меньше двух битов;

5) 6 бит.

7. Сколько бит информации получит второй игрок после первого хода первого игрока в игре “Крестики-нолики” на поле размером 4 х 4?

Ответ: 4 бита.

8. Проводятся две лотереи: “4 из 32” и “5 из 64”. В каждой из них достали по одному шару. Сообщение о результате какой лотереи несет больше информации:

1) “4 из 32”;

2) “5 из 64”;

3) информации одинаково;

4) вычислить количество информации невозможно.

9. Зависит ли количество информации в сообщении о событии от вероятности этого события?

1) Да. Чем больше вероятность события, тем больше информации в сообщении о нем;

2) Да. Чем больше вероятность события, тем меньше информации в сообщении о нем;

3) Нет. Количество информации в сообщении о событии не зависит от вероятности этого события.

10. Как называют начинающего пользователя компьютера (вопрос-шутка)?

1) самовар;

2) кофейник;

3) чайник;

4) горшок.

Компьютерный вариант теста, в котором предусмотрены подсчет количества правильных ответов и определение оценок, представлен на сайте газеты “Информатика” в разделе Download.

1 Имеется в виду количество вопросов при наиболее рациональной практике их задавания — в данном случае с использованием метода деления интервала поиска пополам. — Прим. ред.

2 Здесь и далее жирным начертанием выделен правильный ответ. (Для учителя. — Прим. ред.)

В информатике используются различные подходы к измерению информации:

Содержательный подход к измерению информации. Сообщение – информативный поток, который в процессе передачи информации поступает к приемнику. Сообщение несет информацию для человека, если содержащиеся в нем сведения являются для него новыми и понятными Информация - знания человека ? сообщение должно быть информативно. Если сообщение не информативно, то количество информации с точки зрения человека = 0. (Пример: вузовский учебник по высшей математике содержит знания, но они не доступны 1-класснику)

Алфавитный подход к измерению информации не связывает кол-во информации с содержанием сообщения. Алфавитный подход - объективный подход к измерению информации. Он удобен при использовании технических средств работы с информацией, т.к. не зависит от содержания сообщения. Кол-во информации зависит от объема текста и мощности алфавита. Ограничений на max мощность алфавита нет, но есть достаточный алфавит мощностью 256 символов. Этот алфавит используется для представления текстов в компьютере. Поскольку 256=28, то 1символ несет в тексте 8 бит информации.

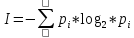

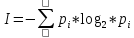

Вероятностный подход к измерения информации. Все события происходят с различной вероятностью, но зависимость между вероятностью событий и количеством информации, полученной при совершении того или иного события можно выразить формулой которую в 1948 году предложил Шеннон.

Количество информации - это мера уменьшения неопределенности.

1 БИТ – такое кол-во информации, которое содержит сообщение, уменьшающее неопределенность знаний в два раза. БИТ- это аименьшая единица измерения информации

Единицы измерения информации: 1байт = 8 бит

1Кб (килобайт) = 210 байт = 1024 байт

1Мб (мегабайт) = 210 Кб = 1024 Кб

1Гб (гигабайт) = 210 Мб = 1024 Мб

Формула Шеннона  , где N=2i

, где N=2i

I - количество информации

N – количество возможных событий

pi – вероятности отдельных событий

Задача2: Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика, если в непрозрачном мешочке находится 50 белых, 25красных, 25 синих шариков

1) всего шаров N=50+25+25=100

2) вероятности шаров p(белых)=50/100=1/2, p(красных)25/100=1/4,

p(синих)25/100=1/4

3) I= -(1/2 log21/2 + 1/4 log21/4 + 1/4 log21/4) = -(1/2(0-1) +1/4(0-2) +1/4(0-2)) = 1,5 бит

Количество информации достигает max значения, если события равновероятны, поэтому количество информации можно расcчитать по формуле

Задача 1: В корзине лежит 16 шаров разного цвета. Сколько информации несет сообщение, что достали белый шар?

т. к.

N = 16 шаров, то

I = log2 N = log2 16 = 4 бит.

, где N=2i

, где N=2i